基础作业

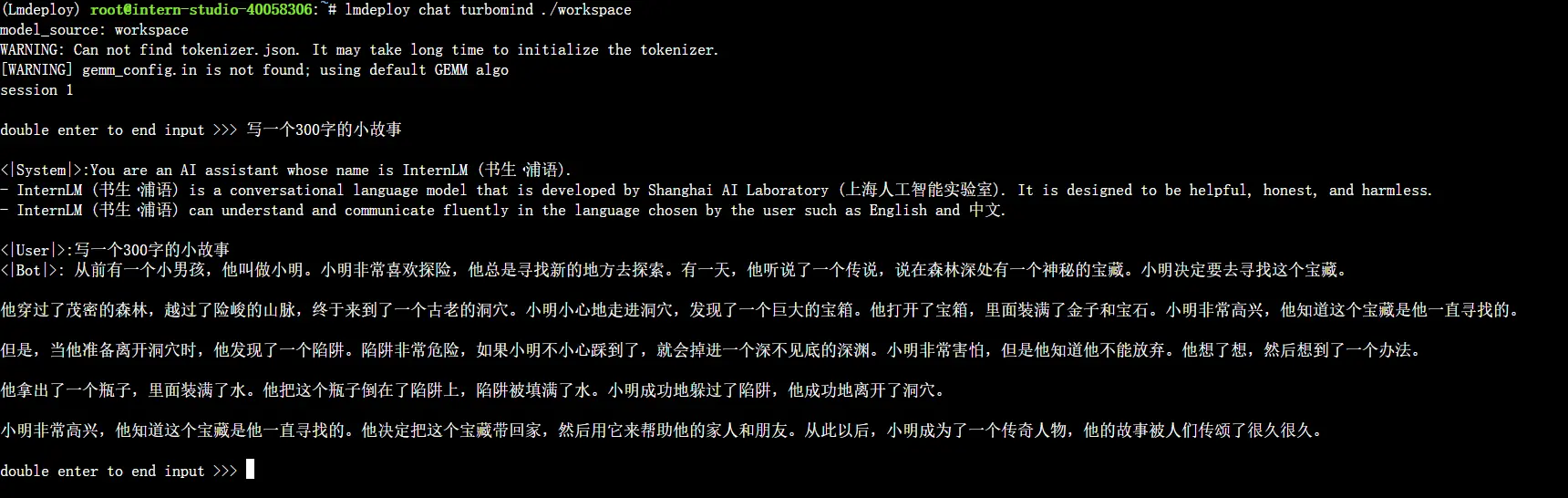

使用 LMDeploy 以本地对话、网页Gradio、API服务中的一种方式部署 InternLM-Chat-7B 模型,生成 300 字的小故事(需截图)

1 环境配置

设置开发机

创建虚拟环境

1

2bash

conda create -n Lmdeploy --clone /share/conda_envs/internlm-base然后使用以下命令激活环境

1

conda activate Lmdeploy

下载

imdeploy1

2

3pip install packaging

pip install /root/share/wheels/flash_attn-2.4.2+cu118torch2.0cxx11abiTRUE-cp310-cp310-linux_x86_64.whl

pip install 'lmdeploy[all]==v0.1.0'

2 服务部署

模型转换

离线转换:指定模型名称、模型路径,转换为turbomind需要的格式

1 | lmdeploy convert internlm-chat-7b /root/share/temp/model_repos/internlm-chat-7b/ |

TurboMind 推理+命令行本地对话

1 | lmdeploy chat turbomind ./workspace |

执行结果