基础作业

面向GPU的环境安装

1 |

|

数据准备

1 | # 解压评测数据集到 data/ 处 |

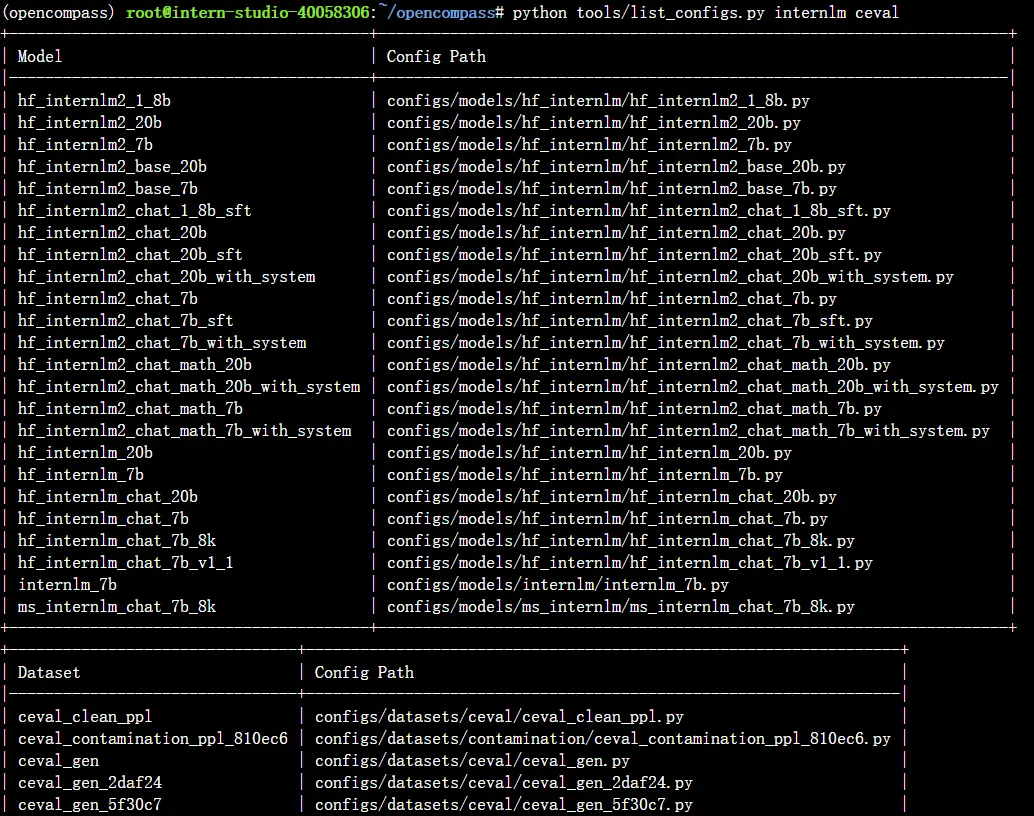

查看支持的数据集和模型

1 | # 列出所有跟 internlm 及 ceval 相关的配置 |

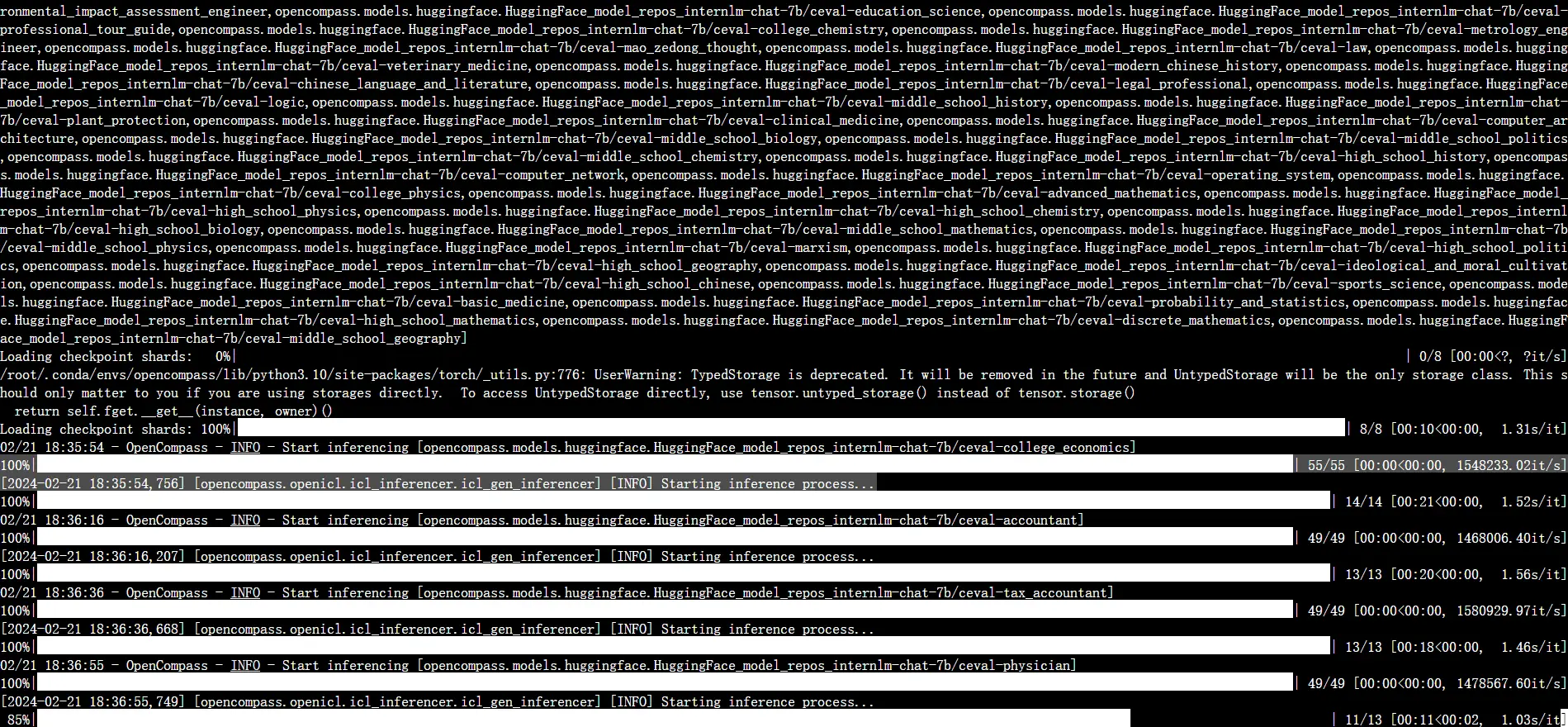

启动评测

1 | python run.py --datasets ceval_gen --hf-path /share/temp/model_repos/internlm-chat-7b/ --tokenizer-path /share/temp/model_repos/internlm-chat-7b/ --tokenizer-kwargs padding_side='left' truncation='left' trust_remote_code=True --model-kwargs trust_remote_code=True device_map='auto' --max-seq-len 2048 --max-out-len 16 --batch-size 4 --num-gpus 1 --debug |

命令解析1

2

3

4

5

6

7

8

9

10--datasets ceval_gen \

--hf-path /share/temp/model_repos/internlm-chat-7b/ \ # HuggingFace 模型路径

--tokenizer-path /share/temp/model_repos/internlm-chat-7b/ \ # HuggingFace tokenizer 路径(如果与模型路径相同,可以省略)

--tokenizer-kwargs padding_side='left' truncation='left' trust_remote_code=True \ # 构建 tokenizer 的参数

--model-kwargs device_map='auto' trust_remote_code=True \ # 构建模型的参数

--max-seq-len 2048 \ # 模型可以接受的最大序列长度

--max-out-len 16 \ # 生成的最大 token 数

--batch-size 2 \ # 批量大小

--num-gpus 1 # 运行模型所需的 GPU 数量

--debug

显示 “Starting inference process”:

1 | [2024-02-21 18:35:54,756] [opencompass.openicl.icl_inferencer.icl_gen_inferencer] [INFO] Starting inference process... |

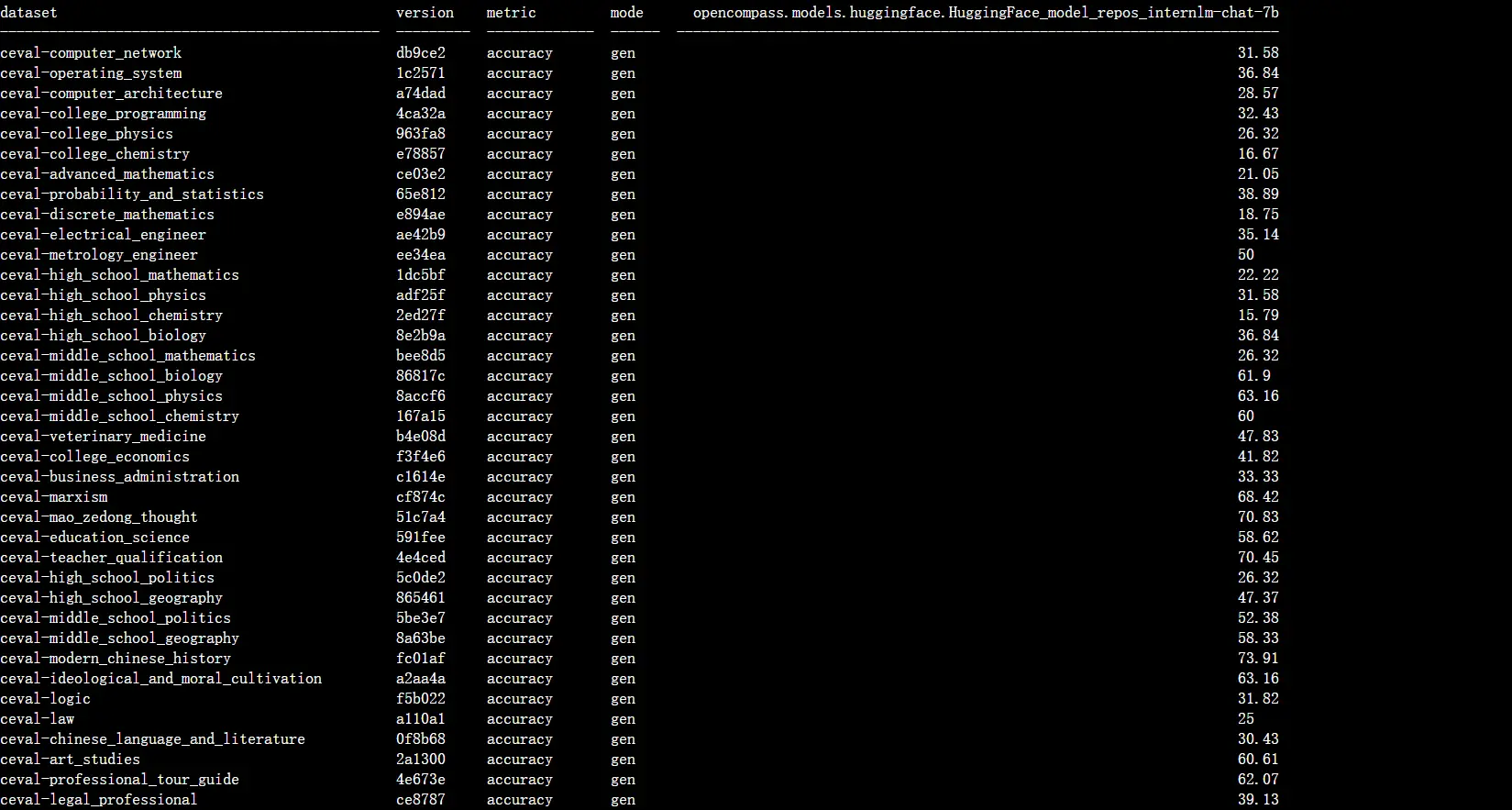

评测完成后,将会看到: