XTuner InternLM-Chat 个人小助手认知微调实践

1.概述

目标:通过微调,帮助模型了解对自己身份

方式:使用XTuner进行微调

2.实操

2.1微调环境准备

1 | 沿用lesson4创建的xtuner0.1.9环境 |

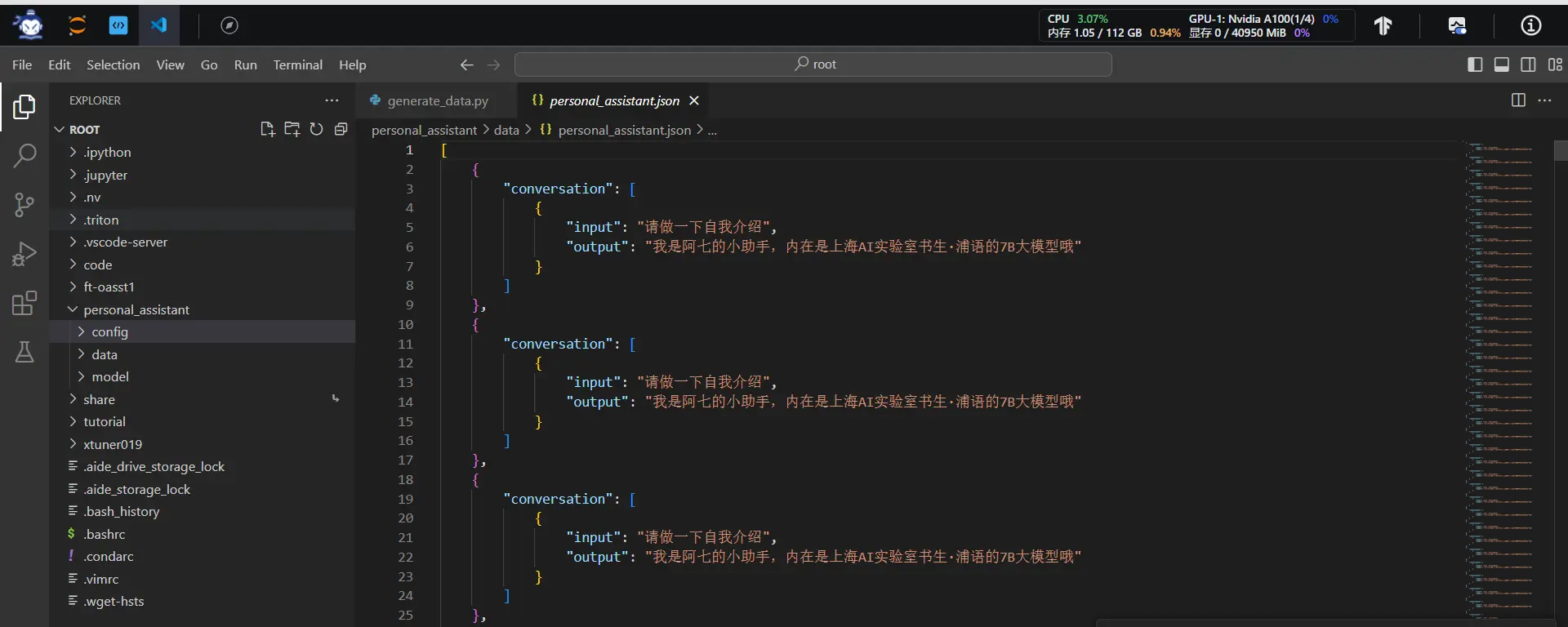

2.2数据准备

创建data文件夹用于存放用于训练的数据集

1 | mkdir -p /root/personal_assistant/data && cd /root/personal_assistant/data |

在data目录下创建一个json文件personal_assistant.json作为本次微调所使用的数据集。json中内容可参考下方(复制粘贴n次做数据增广,数据量小无法有效微调,下面仅用于展示格式,下面也有生成脚本)

其中conversation表示一次对话的内容,input为输入,即用户会问的问题,output为输出,即想要模型回答的答案。

1 | [ |

以下是一个python脚本,用于生成数据集。在data目录下新建一个generate_data.py文件,将以下代码复制进去,然后运行该脚本即可生成数据集。

1 | import json |

2.3配置准备

下载模型InternLM-chat-7B

InternStudio 平台的 share 目录下已经为我们准备了全系列的 InternLM 模型,可以使用如下命令复制internlm-chat-7b:

1 | mkdir -p /root/personal_assistant/model/Shanghai_AI_Laboratory |

XTuner 提供多个开箱即用的配置文件,用户可以通过下列命令查看:

1 | # 列出所有内置配置 |

1 | #创建用于存放配置的文件夹config并进入 |

拷贝一个配置文件到当前目录:xtuner copy-cfg ${CONFIG_NAME} ${SAVE_PATH}

在本例中:

1 | xtuner copy-cfg internlm_chat_7b_qlora_oasst1_e3 . |

修改拷贝后的文件internlm_chat_7b_qlora_oasst1_e3_copy.py

红框为配置文件中PART 3需要修改的内容

1 | # PART 1 中 |

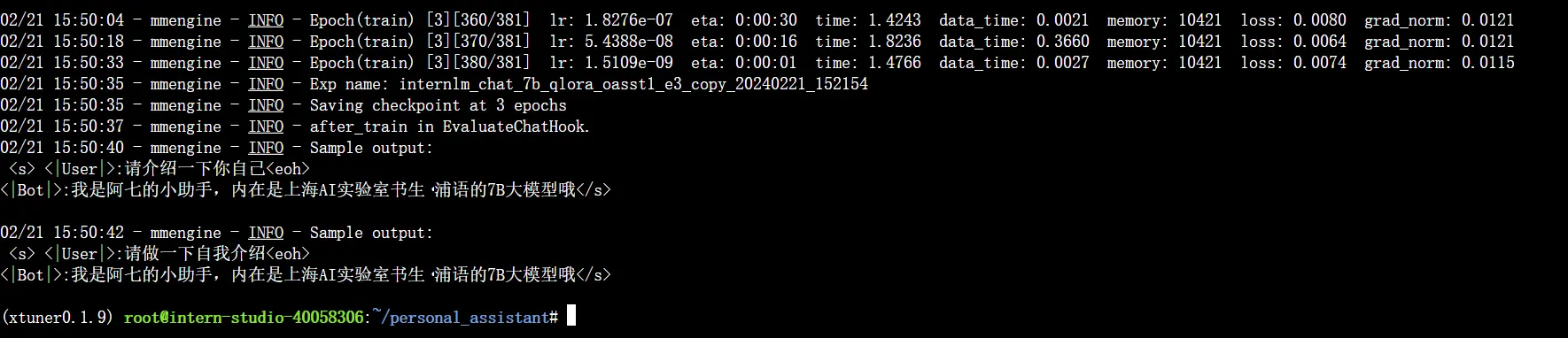

2.4微调启动

用xtuner train命令启动训练、

1 | xtuner train /root/personal_assistant/config/internlm_chat_7b_qlora_oasst1_e3_copy.py |

会在训练完成后,输出用于验证的Sample output

2.5微调后参数转换/合并

训练后的pth格式参数转Hugging Face格式

1 | # 创建用于存放Hugging Face格式参数的hf文件夹 |

Merge模型参数1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19export MKL_SERVICE_FORCE_INTEL=1

export MKL_THREADING_LAYER='GNU'

# 原始模型参数存放的位置

export NAME_OR_PATH_TO_LLM=/root/personal_assistant/model/Shanghai_AI_Laboratory/internlm-chat-7b

# Hugging Face格式参数存放的位置

export NAME_OR_PATH_TO_ADAPTER=/root/personal_assistant/config/work_dirs/hf

# 最终Merge后的参数存放的位置

mkdir /root/personal_assistant/config/work_dirs/hf_merge

export SAVE_PATH=/root/personal_assistant/config/work_dirs/hf_merge

# 执行参数Merge

xtuner convert merge \

$NAME_OR_PATH_TO_LLM \

$NAME_OR_PATH_TO_ADAPTER \

$SAVE_PATH \

--max-shard-size 2GB

2.6网页DEMO

安装网页Demo所需依赖

1 | pip install streamlit==1.24.0 |

下载InternLM项目代码(欢迎Star)

1 | # 创建code文件夹用于存放InternLM项目代码 |

将 /root/personal_assistant/code/InternLM/web_demo.py 中 29 行和 33 行的模型路径更换为Merge后存放参数的路径 /root/personal_assistant/config/work_dirs/hf_merge

运行 /root/personal_assistant/code/InternLM 目录下的 web_demo.py 文件,输入以下命令后,在本地浏览器输入 http://127.0.0.1:6006 即可。

1 | streamlit run /root/personal_assistant/code/InternLM/web_demo.py --server.address 127.0.0.1 --server.port 6006 |

注意:要在浏览器打开 http://127.0.0.1:6006 页面后,模型才会加载。

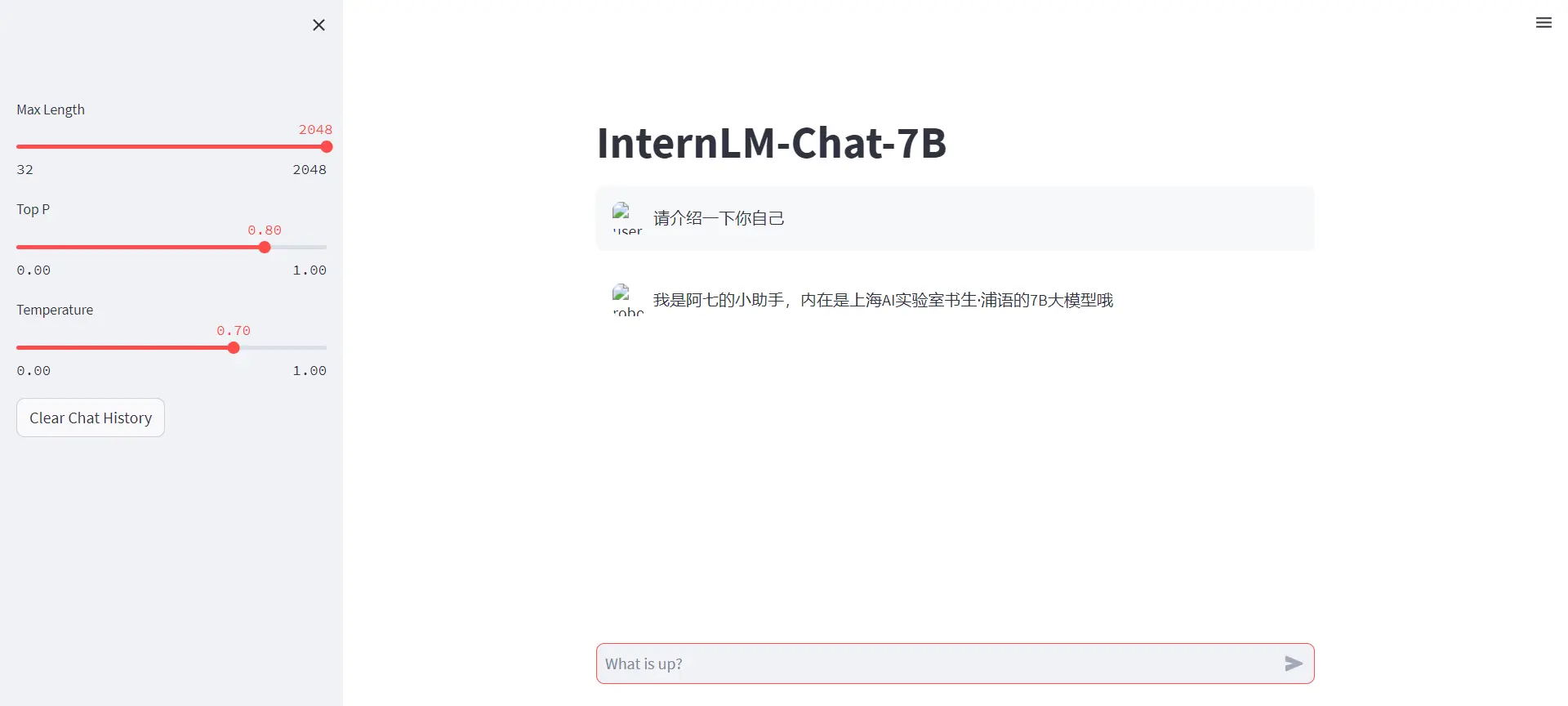

在加载完模型之后,就可以与微调后的 InternLM-Chat-7B 进行对话了

3.效果

请介绍一下你自己

微调前

微调后