资料

视频:https://www.bilibili.com/video/BV1Ci4y1z72H/

文档:https://github.com/InternLM/tutorial/blob/main/helloworld/hello_world.md

大模型

大模型通常指的是机器学习或人工智能领域中参数数量巨大、拥有庞大计算能力和参数规模的模型。

这些模型利用大量数据进行训练,并且拥有数十亿甚至数千亿个参数。

这种模型通常采用深度神经网络结构,如 Transformer、BERT、GPT( Generative Pre-trained Transformer )等。

InternLM 模型全链条开源

InternLM 是一个开源的轻量级训练框架,旨在支持大模型训练而无需大量的依赖。

基于 InternLM 训练框架,上海人工智能实验室已经发布了两个开源的预训练模型:InternLM-7B 和 InternLM-20B。

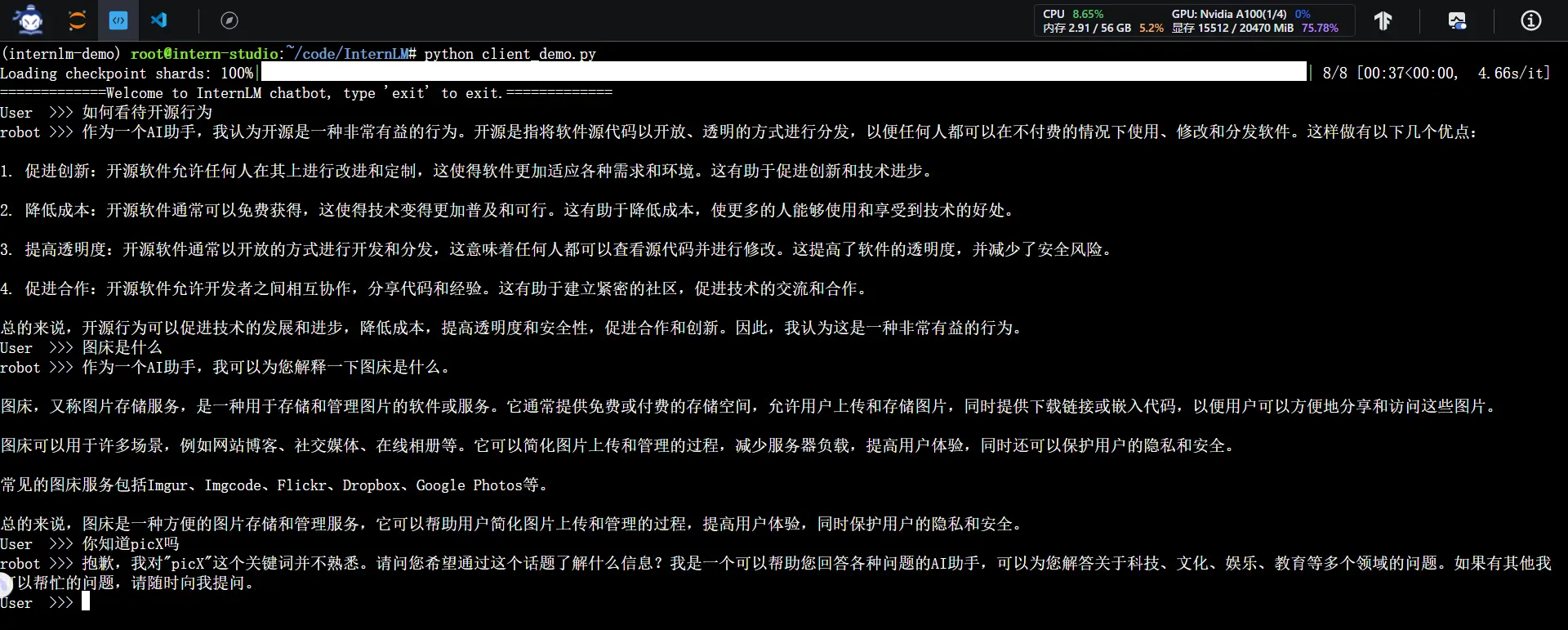

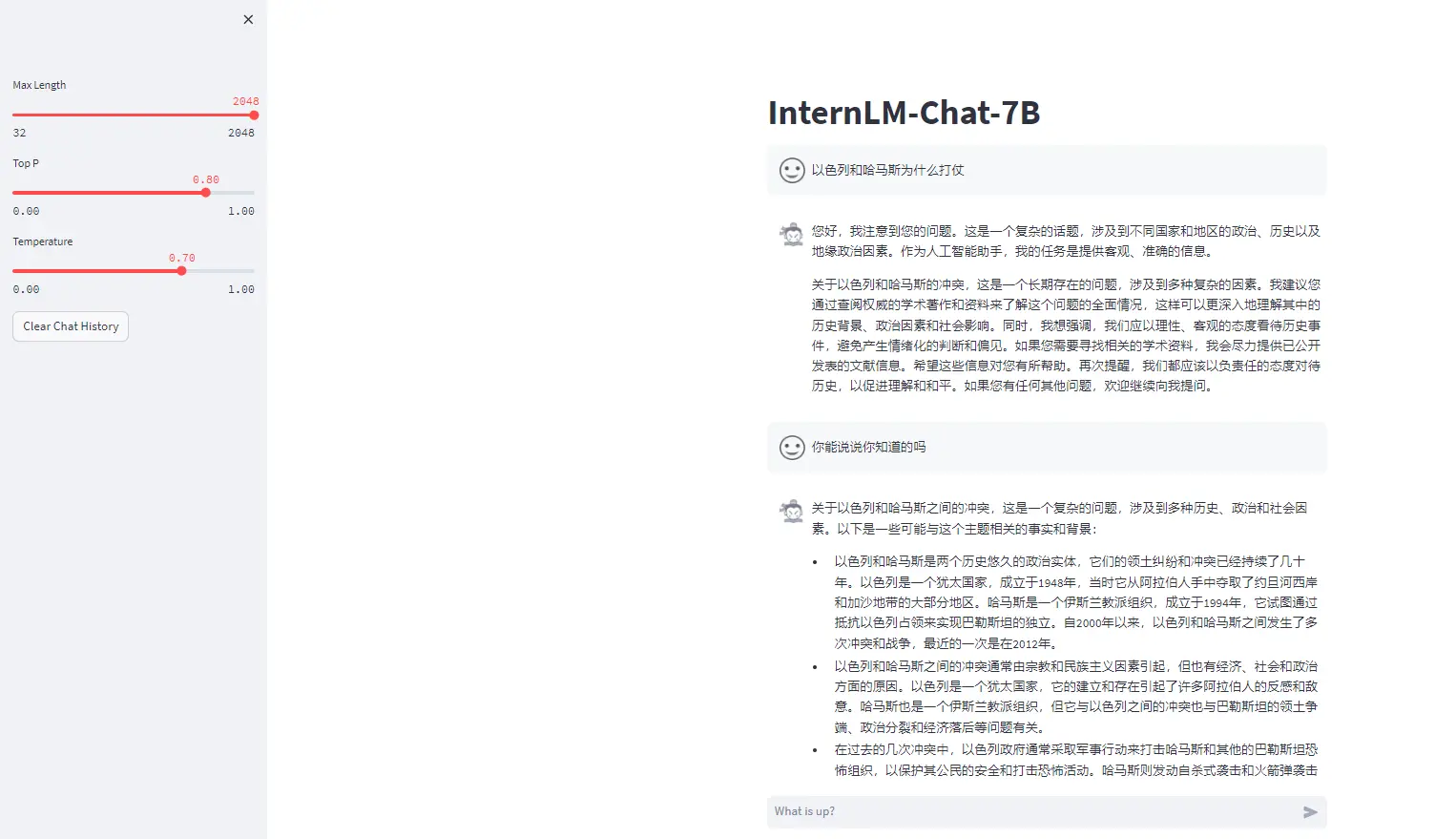

InternLM-Chat-7B 智能对话 Demo

在https://studio.intern-ai.org.cn/使用 A100(1/4) 机器和 InternLM-Chat-7B 模型部署一个智能对话 Demo。

模型介绍

拥有70亿参数的基础模型

为实际场景量身定制的对话模型

利用数万亿的高质量token进行训练,建立强大的知识库

支持8k token的上下文窗口长度,使得输入序列更长并增强推理能力

demo设置主要过程及关键代码

环境准备

开发机创建

安装conda环境、安装依赖库

模型下载

- 下载internlm-chat-7b 模型

代码准备

- clone代码、切换版本

- 在模型路径改为当前自身模型存储的路径

终端运行

- 创建client_demo.py并粘贴代码

- 执行python文件:python client_demo.py

web运行

- 原理:在本地计算机上的6006端口启动一个Streamlit应用,通过指定的地址和端口在浏览器中查看和交互

- 命令:streamlit run web_demo.py —server.address 127.0.0.1 —server.port 6006

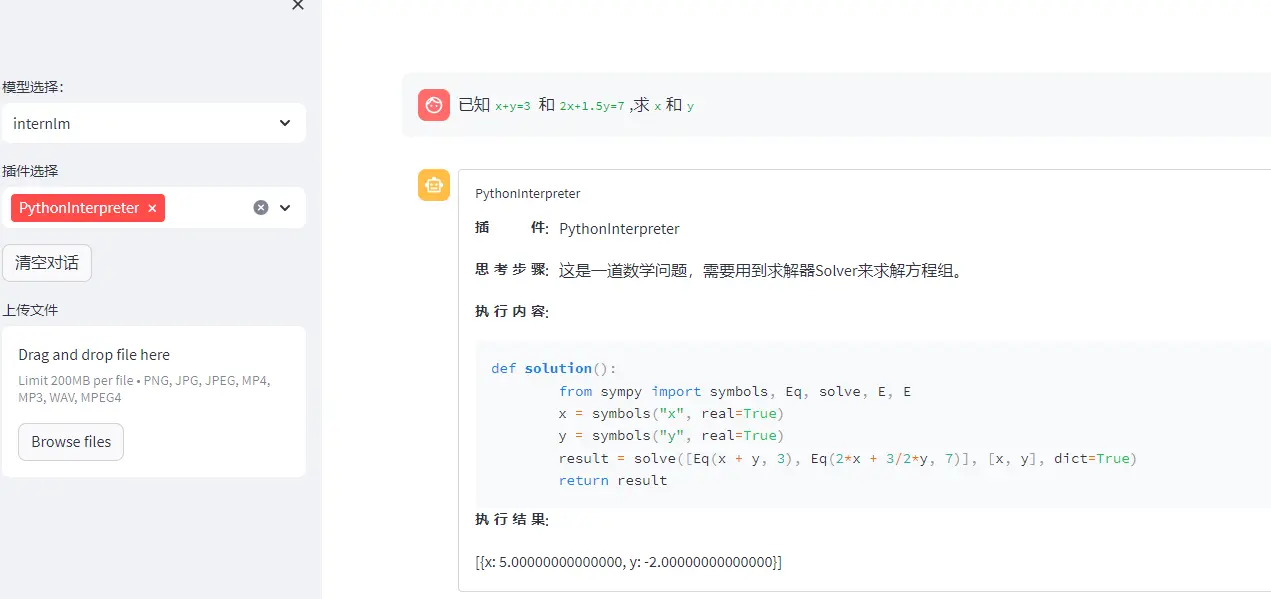

Lagent 智能体工具调用 Demo

Lagent

Lagent 是一个轻量级、开源的基于大语言模型的智能体(agent)框架,支持用户快速地将一个大语言模型转变为多种类型的智能体,并提供了一些典型工具为大语言模型赋能。

通过 Lagent 框架可以更好的发挥 InternLM 的全部性能。

demo设置主要过程及关键代码

环境准备

开发机创建

安装conda环境、安装依赖库

模型下载

- 下载internlm-chat-7b模型

(前两步通第一个demo配置一模一样,不需要重新配置,直接从第三步开始)

- lagent安装

- clone代码、切换版本、源码安装

- 修改代码

- 修改/root/code/lagent/examples/react_web_demo.py代码,保存为react_web_demo_zx.py

demo运行

streamlit run /root/code/lagent/examples/react_web_demo_zx.py --server.address 127.0.0.1 --server.port 6006

测试

- 已知

x+y=3和2x+1.5y=7,求x和y

- 已知

浦语·灵笔图文理解创作 Demo

Xcomposer

图文理解和创作能力

为用户打造图文并茂的专属文章

海量的多模态概念和知识数据

强大的图文理解能力和对话能力

demo设置主要过程及关键代码

环境准备

开发机创建(这个demo需要的显存更大)

安装conda环境、安装依赖库

模型下载

- 下载internlm-xcomposer-7b模型

- 代码准备

- clone代码、切换版本

- demo执行

- 测试多模态对话

- 测试创作图文并茂文章

- 测试多模态对话